据中关村在线援引麻省理工科技评论报道,OpenAI的联合创始人兼首席科学家Ilya Sutskever近日接受采访,谈及公司及AI行业的未来发展。Sutskever表示,他的首要任务并非制作“下一个GPT或DALL-E”,而是研究如何阻止“超级AI”的失控。他认为ChatGPT可能是有意识的,世界需要清醒地认识到AI真正的力量。总有一天,人类会选择与机器融合。

好好好,你这么报道是吧?!

要我说这些搞新闻媒体的,你们是懂怎么制造焦虑的。我自己去研究了下原文采访,给大家粗略的分解下访谈内容:

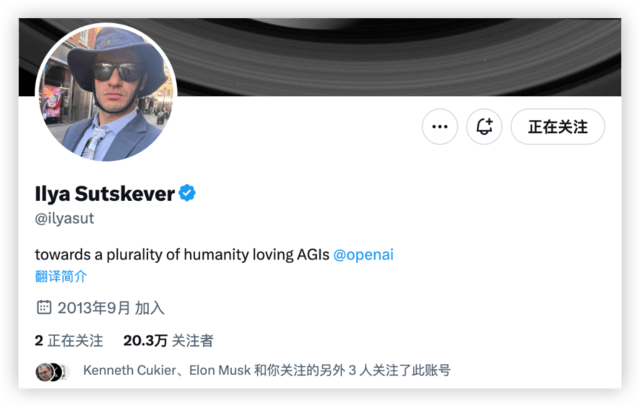

编者注:OpenAI首席科学家Ilya Sutskever的X账号可能是科技界名人里最特别的那种,他极少分享自己的个人生活,除了转发公司产品链接,他的推文通常都是一些零碎的闪念和思考:“自我是成长的敌人”;“GPU就是新时代的比特币”;“如果你把智力看得比人类所有其他品质都重要,那么你会过得很糟糕”;“生活和商业中的同理心被低估了”;“完美毁掉了很多完美的好东西。”更多时候,是为(通用人工智能)AGI站台,正如他的X签名:“打造众多喜欢人类的AGI们”(towards a plurality of humanity loving AGIs)。

他在现实生活里同样如此,Sutskever不热衷社交,很少在媒体前抛头露面。唯一能让他感到兴奋的东西,就是人工智能。近期,Ilya Sutskever接受了《麻省理工科技评论》记者Will Douglas Heaven专访,他在采访中谈到了OpenAI早年的创业史、实现AGI的可能性,还介绍了OpenAI未来在管控“超级智能”方面的计划,他希望让未来的超级智能,可以像父母看待孩子那样看待人类。

以下为正文:

伊尔亚·苏茨克维(Ilya Sutskever)低头沉思。他双臂张开,手指放在桌面上,就像音乐会上即将弹奏第一个音符的钢琴家。我们静静地坐着。

我是来和OpenAI的联合创始人兼首席科学家Sutskever会面的,他的公司位于旧金山传教区一条不起眼的街道上,办公楼没有任何标志,我想听听他一手打造的这项颠覆世界的技术的下一步计划。我还想知道他的下一步计划,尤其是,为什么建立他公司的下一代旗舰生成模型不再是他的工作重点。

Sutskever告诉我,他的新工作重点不是制造下一代GPT或图像制造机DALL·E,而是研究如何阻止AGI(他认为这是一种假想的未来技术)的失控。

Sutskever还告诉了我很多其他事情。他认为ChatGPT可能有意识(如果你眯起眼睛仔细看的话)。他认为,世界需要清醒地认识到他的公司和其他公司正在努力创造的技术的真正威力。他还认为,总有一天人类会选择与机器融合。

Sutskever说的很多话都很疯狂,但不像一两年前听起来那么疯狂。正如他自己告诉我的那样,ChatGPT已经改写了很多人对未来的预期,把”永远不会发生”变成了”会比你想象的更快发生”。

他说:

“重要的是要讨论这一切的方向。”

他在预测AGI(通用人工智能,像人类一样聪明的AI)的未来时,仿佛它就像另一部iPhone一样信心满满:

“总有一天,AGI会实现。也许来自OpenAI。也许来自别的公司。”

自去年11月发布红极一时的新产品ChatGPT以来,围绕OpenAI的讨论一直令人印象深刻,即使在这个以炒作著称的行业也是如此。没有人不会对这家市值800亿美元的初创公司感到好奇。世界各国领导人寻求(且得到)和CEO Sam Altman私人会面。ChatGPT这个笨拙的产品名称在闲聊中不时出现。

今年夏天,OpenAI的首席执行官Sam Altman花了大半个夏天的时间,进行了长达数周的外联之旅,与政客们亲切交谈,并在世界各地座无虚席的会场发表演讲。但Sutskever并不像他那样是个公众人物,他也不经常接受采访。

他说话时深思熟虑,有条不紊。他会停顿很长时间,思考自己想说什么、怎么说,把问题像解谜一样反复推敲。他似乎对谈论自己不感兴趣。

他说:

“我的生活很简单。我去上班,然后回家。我不做其他事情。一个人可以有很多社交,可以参加很多活动,但我不会。”

但当我们谈到人工智能,谈到他所看到的划时代的风险和回报时,他的眼睛亮了起来:

“AI将万世不朽、震撼整个世界。它的诞生如同开天辟地。”

整篇原文看下来就会发现“ChatGPT可能已经有了意识”这个观点并不是访谈的重点,只不过是被媒体单独拿出来夸大做文章罢了。

说说我看完采访之后的一些想法

关于ChatGPT是否可能具有意识的问题,主流的科学和技术社区普遍认为目前的人工智能系统,包括ChatGPT, 还没有实现真正意义上的意识。这个观点基于几个主要的论点:

- 符号与语义的分离:

- 当前的人工智能系统包括ChatGPT主要基于统计和模式识别,它们可以识别和生成与训练数据中相似的模式,但是缺乏对这些模式背后含义的真正理解。这种现象通常被称为符号与语义的分离(The Symbol Grounding Problem)(Harnad, S., 1990, “The symbol grounding problem”, Physica D: Nonlinear Phenomena, 42(1-3), pp. 335-346)。

- 自我意识的缺失:

- 自我意识是意识的一个重要方面,它涉及到个体对自身存在和状态的认识。目前的AI系统缺乏这种自我意识,它们无法感受或理解自己的存在(Metzinger, T., 2003, “Being No One: The Self-Model Theory of Subjectivity”, MIT Press)。

- 感觉与感知的缺失:

- 感觉和感知是意识的基础,但目前的AI系统缺乏与外界直接交互和感知的能力,它们不能感受痛苦、愉悦或其他任何感觉(Searle, J. R., 1980, “Minds, Brains, and Programs”, Behavioral and Brain Sciences, 3(3), pp. 417-457)。

- 神经生物学基础的缺失:

- 目前的神经网络模型,包括GPT系列,与人脑的结构和功能相去甚远,缺乏神经生物学上关于意识产生和维持的基础(Koch, C., Massimini, M., Boly, M., and Tononi, G., 2016, “Neural correlates of consciousness: progress and problems”, Nature Reviews Neuroscience, 17, pp. 307-321)。

综上所述,尽管ChatGPT显示出在处理和生成自然语言方面的高度能力,但是基于目前的科学和技术理解,它还没有实现真正的意识。在未来,随着神经网络模型和人工智能技术的进一步发展,我们可能会更接近解决这些基本问题,但目前还远远没有达到这一点。

相关文章

他在现实生活里同样如此,Sutskever不热衷社交,很少在媒体前抛头露面。唯一能让他感到兴奋的东西,就是人工智能。近期,Ilya Sutskever接受了《麻省理工科技评论》记者Will Douglas Heaven专访,他在采访中谈到了OpenAI早年的创业史、实现AGI的可能性,还介绍了OpenAI未来在管控“超级智能”方面的计划,他希望让未来的超级智能,可以像父母看待孩子那样看待人类。

他在现实生活里同样如此,Sutskever不热衷社交,很少在媒体前抛头露面。唯一能让他感到兴奋的东西,就是人工智能。近期,Ilya Sutskever接受了《麻省理工科技评论》记者Will Douglas Heaven专访,他在采访中谈到了OpenAI早年的创业史、实现AGI的可能性,还介绍了OpenAI未来在管控“超级智能”方面的计划,他希望让未来的超级智能,可以像父母看待孩子那样看待人类。