Emu3:智源推出的原生多模态世界模型,可实现图像、文本、视频的统一理解和生成

Emu3是什么?

Emu3是由北京智源研究院推出的原生多模态世界模型,旨在简化和提升多模态任务的处理能力。多模态任务指的是同时处理不同类型的数据(如图像、视频、文本等)。与依赖扩散模型(如 Stable Diffusion)或组合架构(如 CLIP 与大型语言模型结合)的传统方法不同,Emu3 采用了 next-token 预测技术,将图像、文本、视频转化为离散的 token,并使用单一的 Transformer 模型进行训练。

Emu3只基于下一个 token 预测,无需扩散模型或组合方法,即可完成文本、图像、视频三种模态数据的理解和生成,官方宣称实现图像、文本、视频大一统。

Emu3的功能特性

- 图像生成:Emu3 通过预测视觉 token 来生成高质量图像,支持灵活的分辨率和风格,不再需要扩散模型,生成过程更为高效。

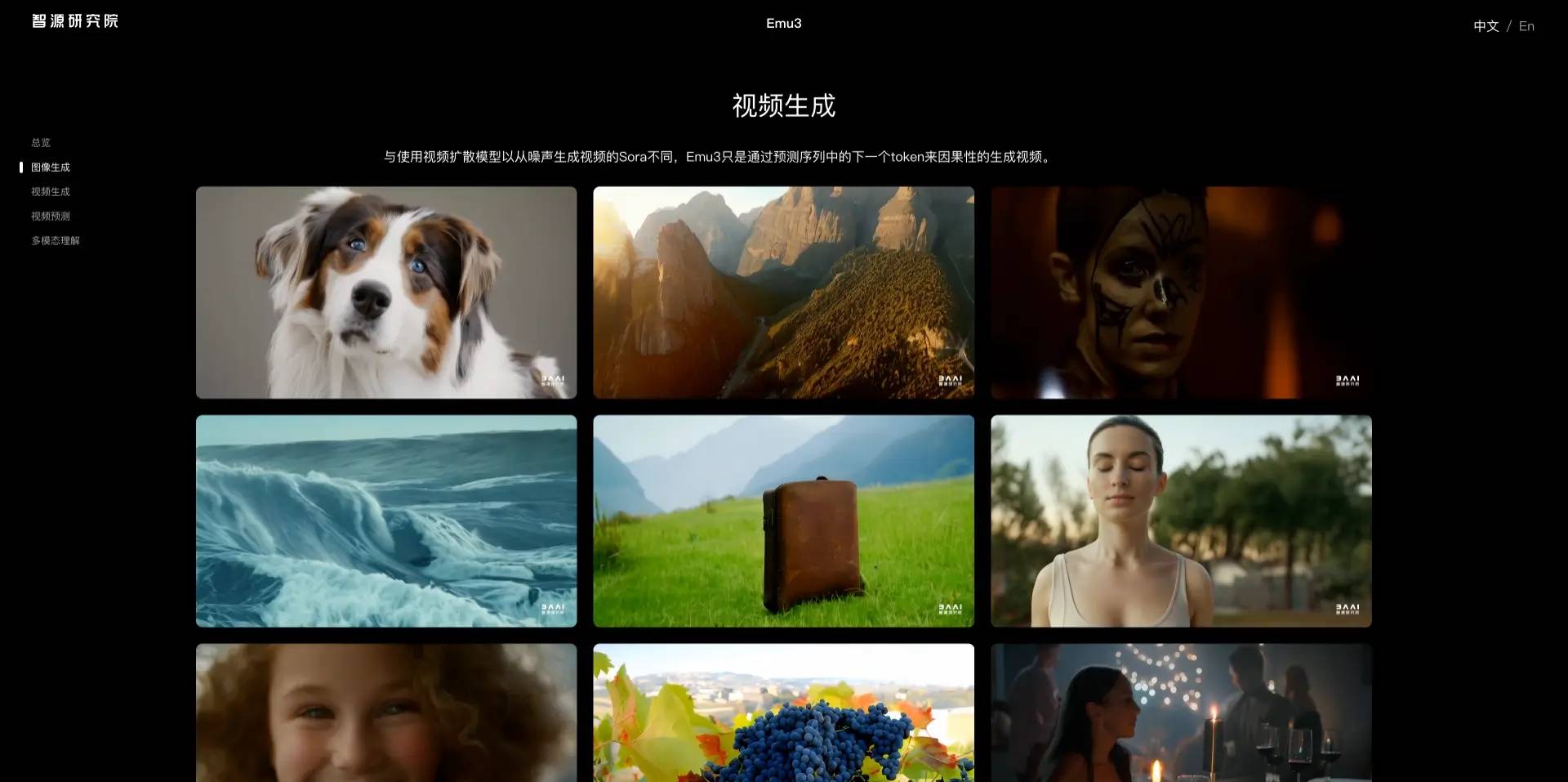

- 视频生成:与依赖噪声生成视频的扩散模型不同,Emu3 通过预测视频序列中的下一个 token 来生成视频,使整个过程更加简洁高效。

- 视频预测:Emu3 能够对视频进行延续预测,模拟现实世界中的环境、人物和动物行为,展现强大的物理世界模拟能力。

- 视觉-语言理解:Emu3 展现了强大的视觉和语言感知能力,可以对图像进行详细描述,并提供连贯的文本回复,而无需依赖 CLIP 和预训练的大型语言模型。

- 多模态整合:Emu3 通过将文本、图像和视频转化为离散 token,并统一使用 Transformer 进行训练,实现了多模态数据的整合。该模型能够在多个领域(图像、视频、文本)表现出色,并且可以同时处理这些不同模态的数据,适用于多模态任务。

- 无扩散、无组合架构:Emu3 的设计抛弃了传统的扩散模型和组合架构,专注于 token 预测。这种设计使得模型在训练和推理过程中能够更高效地扩展。减少了对传统复杂架构的依赖,提高了模型的可扩展性,适用于更多任务和更大规模的数据集。

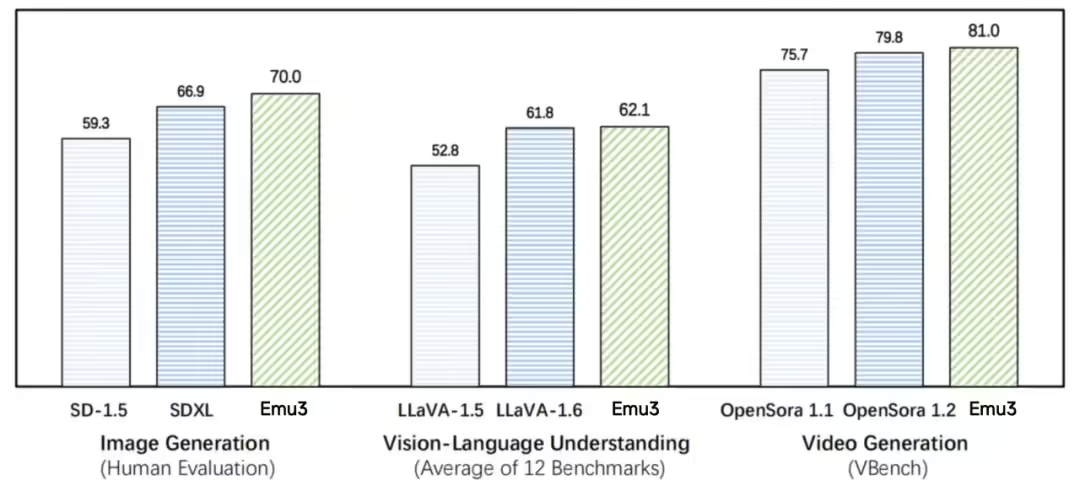

Emu3的性能评测

在图像生成任务中,基于人类偏好评测,Emu3 优于 SD-1.5 与 SDXL 模型。在视觉语言理解任务中,对于 12 项基准测试的平均得分,Emu3 优于 LlaVA-1.6。在视频生成任务中,对于 VBench 基准测试得分,Emu3 优于 OpenSora 1.2。

如何使用Emu3?

目前 Emu3 已开源了关键技术和模型,链接如下:

- Emu3 官网:https://emu.baai.ac.cn/

- Emu3 代码:https://github.com/baaivision/Emu3

- Emu3 模型:https://huggingface.co/collections/BAAI/emu3-66f4e64f70850ff358a2e60f

数据评估

关于Emu3:智源推出的原生多模态世界模型,可实现图像、文本、视频的统一理解和生成特别声明

本站做视频AI导航网提供的Emu3:智源推出的原生多模态世界模型,可实现图像、文本、视频的统一理解和生成都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由做视频AI导航网实际控制,在2024年10月22日 下午9:35收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,做视频AI导航网不承担任何责任。

相关导航

CPM-Bee大模型,百亿参数的开源中英文双语基座大模型

Qwen2.5:阿里巴巴最新开源的系列AI大模型

Qwen2.5是什么? Qwen是阿里巴巴集团Qwen团队研...

悟道

智源“悟道”大模型,中国首个+世界最大人工智能大模型

MiLM 小米大模型

小米大模型MiLM-6B项目地址及小爱同学大模型版邀测招募入...

Seed-Music:字节跳动推出的AI音乐大模型,支持一键生成高质量歌曲

Seed-Music是由豆包大模型团队自主研发的音乐大模型...

MathGPT官网

好未来自研的数学大模型官网入口地址

Llama 3.2:Meta最新推出的开源模型,包括视觉大语言模型和设备端纯文本模型

Llama 3.1是Meta最新推出的开源大语言模型,包括9...

Mistral AI

Mistral AI 推出了 Mistral 7B,这是一种...